近日,有位对技术一窍不通的朋友说想买特斯拉,因为它配备了“你站着不动,让车来找你”的自动驾驶功能。

我大吃一惊,这让人感觉到:自动驾驶虽然暂时还只是从业者关注的话题,但也许用不了几年,就会成为影响普通群众购车决策的关键因素。

既然如此,作为普通人也有必要提前了解一下自动驾驶的关键技术,但没必要像从业者那样了解得那么细致。本回答就面向普通群众作一个通俗易懂的介绍。

自动驾驶需要什么技术?

自动驾驶需要什么技术?要回答这一问题,其实没必要翻开书本,只需要回想一下平时咱们是怎么开车的:

- 眼睛的环境感知:车道在哪?红灯还是绿灯?唉哟,怎么突然窜出个电瓶车?哎呀,离大货车有点太近了!这些工作,都是由超广角、快速对焦、无级调光圈、双目即时测距、损伤自修复[1]的超高性能仿生摄像头——眼睛来完成的。

更为重要的是,此仿生摄像头自带极强的(人工)智能处理器,自动完成图像处理(剔除毛细血管的遮挡、插帧补全盲点像素等)、对象识别(红绿灯、车道)、轨迹预测(电瓶车将要冲出来)等功能之后,再将这些信息上报给“上层意识”。

- 大脑的行为决策:通过环境感知的信息,来判断车辆需要执行的控制策略:前面没车,赶紧加油跑;电瓶车冲出来了,赶紧踩刹车。还要提到的是,像“今天走不走高速”的路径规划也属于广义的决策功能。

- 手脚的车辆控制:收到大脑的决策指令后,驾驶员的神经、四肢,以油门刹车与方向盘作为人车交互的两大媒介,与整个汽车系统一起承担着车辆控制的功能。

什么是自动驾驶?

——就是全部或部分替代这些本来由人来执行的功能。

自动驾驶需要哪些技术?

——自然而然地,需要环境感知、行为决策(广义)与车辆控制技术。

那么,哪项技术在当下的技术门槛最高、最关键呢?

首先,我们可以将车辆控制技术排除在外。这并不是说车辆控制技术简单,L1 级自动驾驶只能帮驾驶员自动加减速或自动转向,进步到 L2 级的“同时实现加减速和转向”,也是花了汽车行业好长时间。

但是,它总体上是一个机电控制的工程问题,相关技术与供应链基本成熟;虽然高阶自动驾驶出于安全性考虑,未来还会有制动和转向的冗余备份要求,总归是逃不出工程领域,而工程问题终究是能解决的。

其次,至于行为决策(广义),像路径规则这种功能,导航软件已经做得比人还好了;在环境感知做到绝对正确的情况下,什么时候加速、什么时候刹车、什么时候转向的决策,也并不难(可能还涉及到一些法律与伦理问题,不属于技术领域)。

如此一来,剩下的就是环境感知了。环境感知对于汽车行业是一个新的挑战,也是实现自动驾驶最关键的一步,是最重要的环节。

环境感知的两种技术路线

正是因为环境感知太难实现,才引发了技术路线上的差异。最有意思的标志性事件,是特斯拉的创始人马斯克在发布自家 Autopilot 3.0 的时候,扔出一句颇具争议的话,炮轰了大半个自动驾驶行业:

“激光雷达太蠢了,谁依靠激光雷达谁就会完蛋。

(Lidar is a fool. Anyone relying on lidar is doomed)”。

激光雷达(Lidar)是什么?马斯克为什么这么说?

要回答这一问题,就要提到自动驾驶环境感知的两大技术路线:弱感知 + 超强智能 vs 强感知 + 强智能。

一、弱感知 + 超强智能

马斯克在发言中坚持的弱感知 + 超强智能技术路线,是指主要依赖摄像头与深度学习技术实现环境感知,而不依赖于激光雷达。

这种技术路线有点仿生学的味道:既然人可以靠一双眼睛就可以开车,那么车也可以靠摄像头来看清周围环境。对于把第一性原理当成颠覆式创新秘诀的马斯克来说,坚信这种技术路线可以说是意料之中。

我也很喜欢这种具备自然美感的技术路线,但问题在于:超强智能何时才能实现?

要知道,技术路线之争要讲究商业化的节奏与速度。一百年前,内燃机没有电机的电磁学简洁美感,但内燃机汽车还是打败了电动汽车;十几年前,等离子电视并非一无是处,但还是败给了液晶电视。

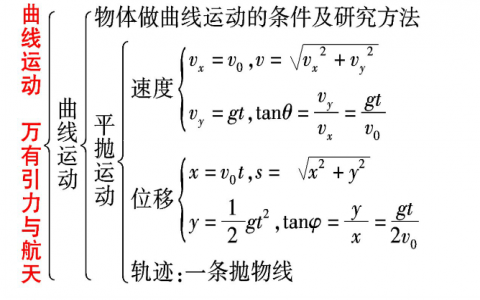

现实问题是,深度学习现在还停留在尴尬的“识别”阶段。就比如,发表在 Nature 上的「Why deep-learning AIs are so easy to fool」一文[2]举了一个例子:特征非常明显的一个“STOP“标志,变换角度之后就被 AI 识别成了哑铃(Dumb-bell)与球拍(Racket)。

这就很僵硬了。这样的识别结果,怕是还不如隔壁村的二傻子吧?

所谓的“弱“感知与“超强“智能都是相对的。我们觉得人类眼睛的视觉很强了,是因为就连再愚钝的人类也配备了超强智能的识别能力,只是大家习以为常、没有留意而已。

上述情况还是在光线良好的情况下,如果是夜晚、大雾、雨雪的条件下,识别效果还会再打折扣。发生在美国的特斯拉撞大货车的那次“事故”,就是因为摄像头在强反光的情况下把白色的大货车识别成了天空。

识别能力尚且如此,那后续的行为预测与逻辑推理就更是无源之水了。因此,当前水平的深度学习,离人类的“超强智能“还是有差距的;至于什么时候能达到甚至超过人类的水平,不知道。

在深度学习技术的进步速度存在诸多未知的情况下,自动驾驶行业总不能停下来等待吧?于是,另外一个思路出现了: 如果超强智能暂时难以达到,那我们给车赋予超过人类眼睛的感知能力啊,是不是也行呢?这就是强感知 + 强智能的技术路线。

二、强感知 + 强智能

与弱感知 + 超强智能的技术路线相比,强感知 + 强智能技术路线的最大特征,就是增加了激光雷达这个传感器,从而大幅提高感知能力。

在介绍激光雷达的原理之前,我们先通俗地打个比方:这可以说是一种暴力解决方案,用千里眼把所有角落都扫一遍,理论上周围有啥都能知道;再加上稍微一点学习算法,就可以勾勒出障碍物的范围,知道车往哪里开了。

就像葫芦娃中的二娃,他不像铁娃、火娃一样拥有暴力技能,作为心地单纯、缺乏计谋(非超强智能)的毛孩子,通常来说碰到妖怪只能束手就擒。但事实上,凭借着千里眼的特异功能(强感知),他也打了不少胜仗。

这种方法听起来有点太耿直,但在目前深度学习遇到瓶颈的情况下,这种技术路线通往高阶自动驾驶可行性更高一些。

事实上,这个技术路线上的玩家并不少,像谷歌 Waymo、百度 Apollo、Uber、福特汽车、通用汽车等人工智能企业、出行企业、传统车企都处在强感知 + 强智能的技术阵营中。

此外,暴力的方案往往也有一种美,比如老毛子的喀秋莎火箭炮,虽然没啥精妙的制导方法,也不需要知道敌人的精确位置,一打起来就把足量的火力送过去,保证覆盖度就行。

下图来源[3]

对于习惯追求暴力美学的老毛子来说,这种方法最保险。对于人命关天的自动驾驶来说,多一些追求保险的观念,也不是什么坏事。

环境感知的关键传感器

无论何种技术路线,环境感知的核心都在于“传感器”(Sensor)这一古老的名词。咱们前面提到的摄像头与激光雷达,都是传感器。

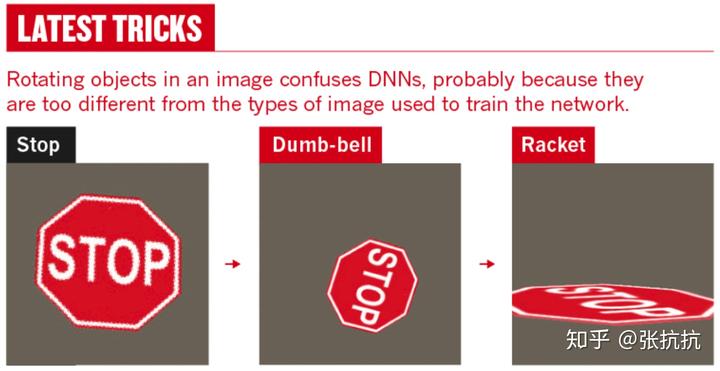

除了这俩之外,与自动驾驶关系密切的传感器还包括另外两种雷达:超声波雷达(Ultrasound Radar)与毫米波雷达(Radar)。

突然多了好几个专业名词,是不是头都要大了? 一开始我也有这种感觉,后来自己总结出一个简便的记忆方式,给大家分享一下:

- 摄像头:依靠别人、通过第三方发射波(光也是一种波)感知信息的,叫摄像头;

- 雷达:自给自足、通过自己发射波来感知信息的,叫雷达。

- 不同雷达:根据探测距离、分辨率等因素不同,三种雷达被区分为超声波雷达、毫米波雷达(1-10mm)、激光雷达。大体上来说,激光雷达探测距离最长、分辨率最高。

下图来源[4]

关于激光雷达的原理,可以理解为数字量:一条激光过去是直的,相当于数字扫点,理论上把所有周围的点扫一遍,就能清楚知道周围环境是什么样。

其实,对车辆造型扫描(逆向)也就是这个原理。

当然,实际的工程应用中,还是有不少细节问题。前文提到激光雷达的分辨率很高,那就意味着每次只能扫了很小一块区域,这就意味着要解决两个问题:

- 空间覆盖率:只看一小块区域不行啊,咱们要看全部!那怎么拼呢?一般来说,纵向靠多线,也就是多发射几根波;横向靠旋转,旋转有机械式的,叫机械激光雷达;也有利用光学相控阵技术来实现的,那就叫固态激光雷达。二者的详细对比参见文章[5]

- 时间一致性:横向扫描是依次进行的,也就有时间差。这短暂的时间差里,车辆自身在运动、周围的环境也在变化,这就需要借助人工智能技术进行“画面重现”。当然,激光雷达扫回来的点是精确的、确定的,并带有深度信息,所以这里只需要依赖“强智能“,而不必是”超强智能“。

与激光雷达不同,摄像头的采集的是像素信息,就和人眼看到的差不多。与人不同的是,人眼配备了超强的(人工)智能处理器,在毫不费力的情况下识别出环境中的车道、车辆、行人等等,而对车辆来说,像素信息只是无意义的海量数字,必须经过如下的抽象、重构等复杂过程,必须依赖超强智能才能达到人类的识别效果。

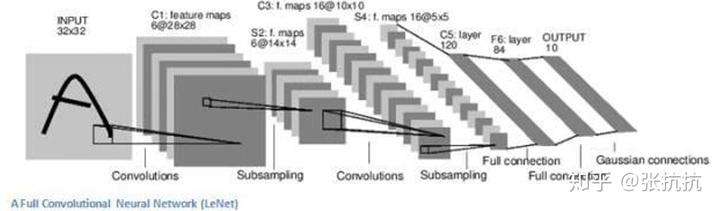

下图来源于一本非常基础的深度学习教材,我们可以看到:即便是一个简单的字符,想准确识别都需要复杂的处理过程。

最后才提到毫米波雷达,似乎暗示着毫米波雷达不重要? 恰恰相反,毫米波雷达非常重要:

- 无论是弱感知 + 超强智能,还是强感知 + 强智能,所有技术路线必备毫米波雷达。

- 无论是当前已成熟的 L2 级自动驾驶, 还是未来 L3、L4、L5 级自动驾驶,在可预见的自动驾驶不同阶段都必备毫米波雷达。

正因为大家都需要毫米波雷达,争议比较少,才不经常拿出来被比较与提及,但这并不意味着它不重要。

本题的提问者 @亚德诺半导体 将上述环境感知传感器放在一起,从各个维度进行了一个全面的比较,比较专业、信息量很大,有兴趣的同学可以仔细看一下。

摄像头与雷达解决了“我周围都有啥“的问题,车辆还需要解决另外一个问题:我在哪,我有多快?

对于日常定位与测速需求来说,单独使用 GPS 足矣;但对于自动驾驶来说,仅使用 GPS 在精度、响应速度与场景覆盖率(隧道、车库)都不够,还需要一种加速度传感器,也就是IMU 惯性测量单元,并通过卡尔曼滤波等方法将二者信息融合,形成最优估计。

吃瓜群众可能有个疑问,明明是测加速度的,为啥叫惯性单元呢?我们回想一下牛顿第二定律,就不言自明了: 加速度 = 作用力 / 惯性(质量)

好了,做一个小结,自动驾驶的环境感知需要完成以下工作:

- 我周围都有啥? 涉及到摄像头、激光雷达、毫米波雷达、超声波雷达等传感器技术。

- 我在哪,我有多快? 涉及到 GPS 与 IMU 惯性测量单元技术。

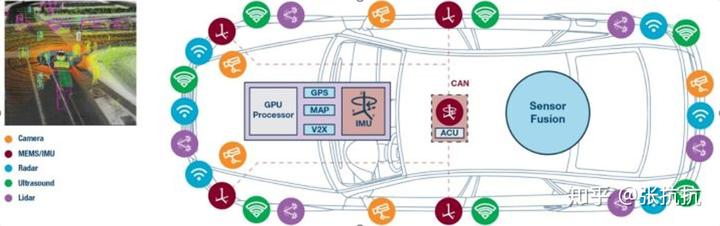

- 这么多信息,我听谁的? 涉及到信息融合技术,如下图来源于 @亚德诺半导体 的文章[6]

大家都知道,自动驾驶是汽车行业的一项革命性技术,蕴含着巨大的商业价值。如果要投身到这个市场,那么问题来了:应该投入到哪项传感器技术呢?

半导体行业领导者 ADI @亚德诺半导体 的回答是:小公司才做选择,大公司我全都做!

- ADI 毫米波雷达:覆盖 24GHz 和 76-81GHz 完整频段,在现今开发的所有雷达模块中占到 50%.

- ADI 激光雷达:收购 Vescent,志在提供质高价低的纯固态激光雷达。

- ADI 惯性单元:高稳定性和超低噪声,高达十个运动自由度,从战术级降维至车规级开发的 IMU,堪称业界超优方案。作为百度 Apollo 的重要合作伙伴,为全球首款 L4 级量产自动驾驶巴士阿波龙提供 IMU 用于惯性导航。

更详细的介绍,请移步官方机构号的这篇文章:

自动驾驶攻破的难点在哪,何时能到 Level 5?

微信扫一扫

微信扫一扫